Brèves

Thème : Intelligence articifielle

Les résumés générés par l’IA provoquent une chute dévastatrice du trafic sur les sites producteurs de contenus

Une étude publiée récemment révèle que les résumés générés par l'IA menace Internet dans sa forme actuelle. Des médias d'information ont vu leur trafic baisser de 80% dès lors qu'un résumé de leurs contenus est proposé par Google AI Overview. Les lecteurs se contentent de cette information et s'abstiennent de pousser leur recherche plus loin. Le recours de plus en plus généralisé à l'IA menace donc les fondements d'Internet. Les grands acteurs du web rapportent des baisses drastiques de la fréquentation de leur site, de Wikipédia jusqu'au aux sites de voyage. Reddit, une importante plateforme de forums a vu la valeur de son action chuter de moitié suite à l'annonce d'une baisse de trafic attribuable à l'arrivée des agents IA. The Economist sonne l'alarme. " Si cette surexploitation du web par l'IA n’est pas stoppée, l’un des grands biens communs de l’humanité pourrait être gravement appauvri. La tragédie du Web serait une tragédie pour tous."

Rapport Apple sur les limites de l'IA: «L’IA ne se heurte pas à un mur. Mais les LLMs oui» selon Gary Marcus

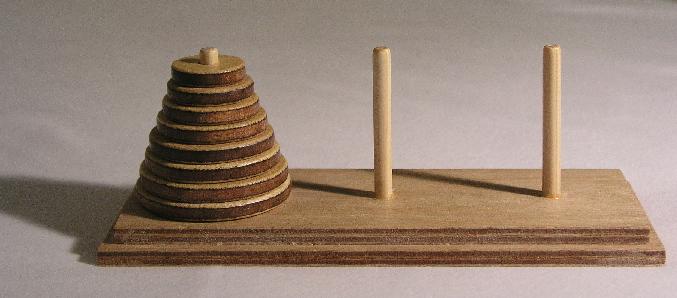

Le rapport publié récemment par Apple a fait l'effet d'une bombe dans le milieu de l'IA. Dans ce résultat d'étude menée par plusieurs chercheurs, dont Sam Bengio, frère de l'expert mondialement connu Yoshua Bengio, attire l'attention des lecteurs sur les limites auxquelles font face les LLM/LRM (Large Language Model/Large Reasoning Model), qui ont tendance à échouer lorsque la complexité du problème à résoudre augmente. L'étude montre entre autre comment ces agents IA peinent à trouver une solution au jeu classique des Tours de Hanoi. Les partisans de l'IA ont vertement critiqué les faiblesses de l'étude alors que les médias grands publics ont fait une large place à cette étude, provenant, rappelons-le, d'un des grands joueurs de la technologie. Gary Marcus, auteur de The Algebraic Mind, professeur à NYU, dont les propos ont été publiés par The Guardian, estime qu'il faut aborder la question avec nuance:

«Toute personne qui pense que les LLMs représentent un chemin direct vers une AGI (Intelligence artificielle générale) capable de transformer radicalement la société pour le bien commun se berce d’illusions.

Cela ne signifie pas que les réseaux neuronaux sont morts, ni que le deep learning est arrivé à sa fin.

L’IA ne se heurte pas à un mur. Mais les LLMs, probablement si — ou du moins ils atteignent un point de rendements décroissants.

Nous avons besoin de nouvelles approches, et de diversifier les voies qui sont explorées activement.»

Lire cet entretien avec Gary Marcus paru dans Le Grand Continent (en français).

L'IA utilisée pour imposer des politiques d'austérité et créer une instabilité permanente

«Aux Etats-Unis, la collusion entre les géants de la tech et l’administration Trump vise à “utiliser l’IA pour imposer des politiques d’austérité et créer une instabilité permanente par des décisions qui privent le public des ressources nécessaires à une participation significative à la démocratie”, explique l’avocat Kevin De Liban à Tech Policy. Aux Etats-Unis, la participation démocratique suppose des ressources. “Voter, contacter des élus, assister à des réunions, s’associer, imaginer un monde meilleur, faire des dons à des candidats ou à des causes, dialoguer avec des journalistes, convaincre, manifester, recourir aux tribunaux, etc., demande du temps, de l’énergie et de l’argent. Il n’est donc pas surprenant que les personnes aisées soient bien plus enclines à participer que celles qui ont des moyens limités. Dans un pays où près de 30 % de la population vit en situation de pauvreté ou au bord de la pauvreté et où 60 % ne peuvent s’offrir un minimum de qualité de vie, la démocratie est désavantagée dès le départ”. L’IA est largement utilisée désormais pour accentuer ce fossé. »

Une recension de Hubert Guillaud - Dans les algorithmes

La Chine limite l'accès aux agents IA pendant la période d'examen scolaire

Selon Bloomberg, les entreprises chinoises spécialisées dans l'IA ont temporairement mis en pause certaines de leurs fonctions de chatbot afin d'empêcher les étudiants de les utiliser pour tricher lors des examens universitaires nationaux. Du 7 au 10 juin, plus de 13,3 millions d'étudiants chinois passent les rigoureux examens nationaux, chaque étudiant se battant pour obtenir l'une des places limitées dans les universités du pays. Il est déjà interdit aux étudiants d'utiliser des appareils tels que les téléphones et les ordinateurs portables pendant les épreuves qui durent plusieurs heures. La désactivation des chatbots d'IA constitue donc un filet de sécurité supplémentaire pour empêcher la tricherie pendant la saison des examens.

À lire dans The Verge (en anglais).

Pour certains jeunes diplômés, l’apocalypse de l’IA, c’est maintenant

«Automatiser les emplois de cols blancs fait rêver les dirigeants d'entreprise depuis des années. Ce fantasme avait animé la conférence de Davos en 2019. Mais la technologie n’était pas assez bonne. On pouvait utiliser l’IA pour certaines tâches routinières des services de soutien – ce qui s’est beaucoup fait –, mais dans les tâches plus complexes et techniques, l’IA n’allait pas à la cheville des humains.

«Automatiser les emplois de cols blancs fait rêver les dirigeants d'entreprise depuis des années. Ce fantasme avait animé la conférence de Davos en 2019. Mais la technologie n’était pas assez bonne. On pouvait utiliser l’IA pour certaines tâches routinières des services de soutien – ce qui s’est beaucoup fait –, mais dans les tâches plus complexes et techniques, l’IA n’allait pas à la cheville des humains.

«Ça commence à changer, en particulier dans des domaines comme le génie logiciel, où on voit clairement si le code marche ou pas. Certaines entreprises prônent désormais l’approche "IA d’abord", encourageant les cadres à toujours voir si une tâche peut être effectuée par l’IA avant d’embaucher un humain.

Le contre-exemple de Klarna

L'engouement pour l'IA n'est pas sans danger. «Certaines sociétés pourraient se tourner vers l’IA trop tôt, avant que les outils soient assez robustes pour gérer tout le travail des débutants. C’est arrivé chez Klarna, une fintech suédoise de crédit à la consommation qui a beaucoup fait parler d'elle en remplacant en 2023 ses agents du service client par des robots d’IA ; après un déluge de plaintes, elle a fait marche arrière et réembauché des humains.»

Article du New York Times, publié en français dans la section Techno de La Presse.

Pour ses suggestions de lectures d'été, le Chicago Sun-Times propose des livres... qui n'existent même pas

Énorme faux pas pour le Chicago Sun-Times qui vient de publier sa liste de suggestions de lectures pour l'été. Le hic : certains titres n'existent tout simplement pas et sont le fruit des hallucinations d'une application d'IA. L'article recommande entre autres Tidewater Dreams d'Isabel Allende, un «premier roman de fiction climatique» où «le réalisme magique rencontre l'activisme environnemental». Les amateurs d'Allende, décus d'apprendre que le livre n'existe pas encore, n'auront probalement pas à attendre fort longtemps pour le lire: il y a fort à parier qu'un éditeur futé le publie d'ici quelques jours sur Amazon – à l'aide de l'IA bien sûr. Que l'intelligence artificielle génère ce genre d'affabulations n'étonnera plus personne, mais qu'un article dont le contenu n'a fait l'objet d'aucune révision par un humain se retrouve dans les pages d'un grand quotidien en dit long sur les dommages que l'usage non encadré de l'IA peut engendrer. Le Chicago Sun-Times a beau plaider son innocence sur Bluesky, ce genre de bévue contribue à l'exaspération du public dont la confiance envers l'IA s'effrite de plus en plus.

Revers cinglant également pour les grandes entreprises de la Silicon Valley qui, selon cette enquête de la MIT Technology Review, rivalisent entre elles avec des investissements astronomiques pour développer de gigantesques centres de traitement de données dans le désert du Nevada. Au risque de compromettre l'alimentation en eau dans la région et la bonne entente avec les tribus ancestrales locales.

Wendell Berry: 9 règles pour les nouvelles technologies

Le fermier-poète américain Wendell Berry écrivait en 1987 que toute nouvelle technologie doit répondre à 9 règles pour s'intégrer harmonieusement dans nos communautés. Le critique de la technique Ted Gioia croit que ces règles sont plus pertinentes que jamais.

Le fermier-poète américain Wendell Berry écrivait en 1987 que toute nouvelle technologie doit répondre à 9 règles pour s'intégrer harmonieusement dans nos communautés. Le critique de la technique Ted Gioia croit que ces règles sont plus pertinentes que jamais.